Event Streaming

Event Streaming

Basis für Echtzeit

Stackable für Event Streaming

Die Stackable Data Platform dient als Basis für moderne Event-Streaming-Architekturen und integriert sich nahtlos in Kubernetes. Durch Nutzung eigener Operatoren und die Einbindung von ausgewählten Open-Source-Data-Apps bietet Stackable eine robuste und flexible Grundlage für die Verarbeitung und Analyse von Echtzeitdaten.

Event Streaming

Event Streaming ist eine dynamische Methode der Datenverarbeitung, die eine kontinuierliche Verarbeitung und Bewegung von Daten in Echtzeit über Systemgrenzen hinweg ermöglicht. Sie ist v.a. für diejenigen Organisationen interessant, die unmittelbare Erkenntnisse und Reaktionen aus ihren Daten benötigen, z. B. bei der Erkennung betrügerischer Transaktionen, der Überwachung von Benutzeraktivitäten in Echtzeit oder der Verwaltung der Lieferkettenlogistik.

Data App Highlights der Stackable Data Platform für Event Streaming

Ermöglicht den Import, das Management des Datenflusses sowie den automatisierten Datenaustausch zwischen Systemen.

- Einfaches Daten-Routing und Transformation: Bietet eine benutzerfreundliche Oberfläche für das Management des Datenflusses und unterstützt die schnelle Entwicklung und Bereitstellung von Verarbeitungspipelines.

- Systemintegration: Verbindet sich mit einer Vielzahl von Datenquellen und -senken und erleichtert die Datenaufnahme aus unterschiedlichen Systemen.

- Data Lineage: Nachverfolgung des Datenflusses von der Quelle bis zum Ziel, Unterstützung von Audits und Compliance.

- Flexibel: Anpassbare Prozessoren und die Fähigkeit, verschiedene Datenformate und -größen zu verarbeiten.

Herzstück der Event-Streaming-Architektur, das robustes, skalierbares Messaging und Stream Processing bietet.

- Hoher Durchsatz: Kann Millionen von Nachrichten pro Sekunde verarbeiten und ist damit ideal für umfangreiche Nachrichtenverarbeitungsaufgaben.

- Skalierbarkeit: Einfache Skalierbarkeit mit minimalen Ausfallzeiten zur Unterstützung wachsender Datenanforderungen.

- Stabilität und Verlässlichkeit: Sorgt dafür, dass Daten nicht verloren gehen und übersteht auch Ausfälle, so dass die Datenintegrität gewahrt bleibt.

- Vielseitigkeit: Unterstützt eine breite Palette von Anwendungsfällen.

Bietet leistungsstarke Stream-Verarbeitungsfunktionen, die komplexe Analysen und maschinelles Lernen auf Streaming-Daten ermöglichen.

- In-Memory-Computing: Beschleunigt die Verarbeitungsgeschwindigkeit, indem es die Daten im RAM speichert, deutlich schneller als festplattenbasierte Alternativen.

- Erweiterte Analysen: Unterstützt komplexe Algorithmen für maschinelles Lernen, Graphenverarbeitung und mehr.

- Fehlertoleranz: Resiliente verteilte Datensätze (RDDs) bieten Fehlertoleranz durch Herkunftsinformationen.

- Sprachunterstützung: Bietet APIs in Python, Java, Scala und R und erweitert damit die Zugänglichkeit und Nutzbarkeit.

Bietet Echtzeit-Analysen und OLAP-Abfragefunktionen, ideal für Einblicke in Streaming-Daten.

- Echtzeit-Analytik: Entwickelt für Abfrage-Antwortzeiten von weniger als einer Sekunde, ideal für interaktive Anwendungen.

- Skalierbar: Bewältigt große Datenmengen und gleichzeitige Benutzer ohne Leistungseinbußen.

- Hohe Verfügbarkeit: Die verteilte Architektur stellt sicher, dass das System immer betriebsbereit ist und Abfragen auch bei Teilausfällen bedienen kann.

- Zeitreihendaten: Optimiert für die Aufnahme und Abfrage von Zeitreihendaten, ideal für Metriken, Überwachung und Ereignisdaten.

Exemplarische Anwendungsfälle

- Echtzeit-Analytik und Überwachung: Implementierung mit Apache Kafka, um Daten zu erfassen und zu streamen, und Verwendung von Apache Spark für die Verarbeitung, um sofortige Einblicke in Geschäftsabläufe, Kundenverhalten und Systemleistung zu erhalten.

- Betrugserkennung: Event-Streaming zur kontinuierlichen Analyse von Transaktionen in Echtzeit mit Apache Kafka und Apache Spark, um potenzielle betrügerische Aktivitäten zu erkennen und zu alarmieren und so das Risiko und die Auswirkungen auf Unternehmen deutlich zu reduzieren.

- Lieferketten-Management: Optimierung von Abläufen, indem Ereignisse in der Lieferkette in Echtzeit überwacht werden. Apache NiFi kann für die Datenerfassung und -weiterleitung verwendet werden, während Apache Kafka die Daten streamt und so sofortige Anpassungen von z.B. Lagerbeständen, Versandplänen und Produktionsplänen ermöglicht.

- IoT-Datenverwaltung: Verwaltung großer Datenströme von IoT-Geräten mit Apache Kafka und Verarbeitung mit Apache Spark. Einsatz von Apache Druid für Echtzeitanalysen zur Überwachung der Gerätezustände, zur Leistungsoptimierung und zur Vorhersage des Wartungsbedarfs.

- Personalisierte Kundenerlebnisse: Sammlung und Verarbeitung von Daten zu Benutzeraktivitäten und -verhalten in Echtzeit, um personalisierte Inhalte, Empfehlungen und Dienste bereitzustellen. Verwendung von Apache Kafka für das Datenstreaming und Apache Spark für die Verarbeitung.

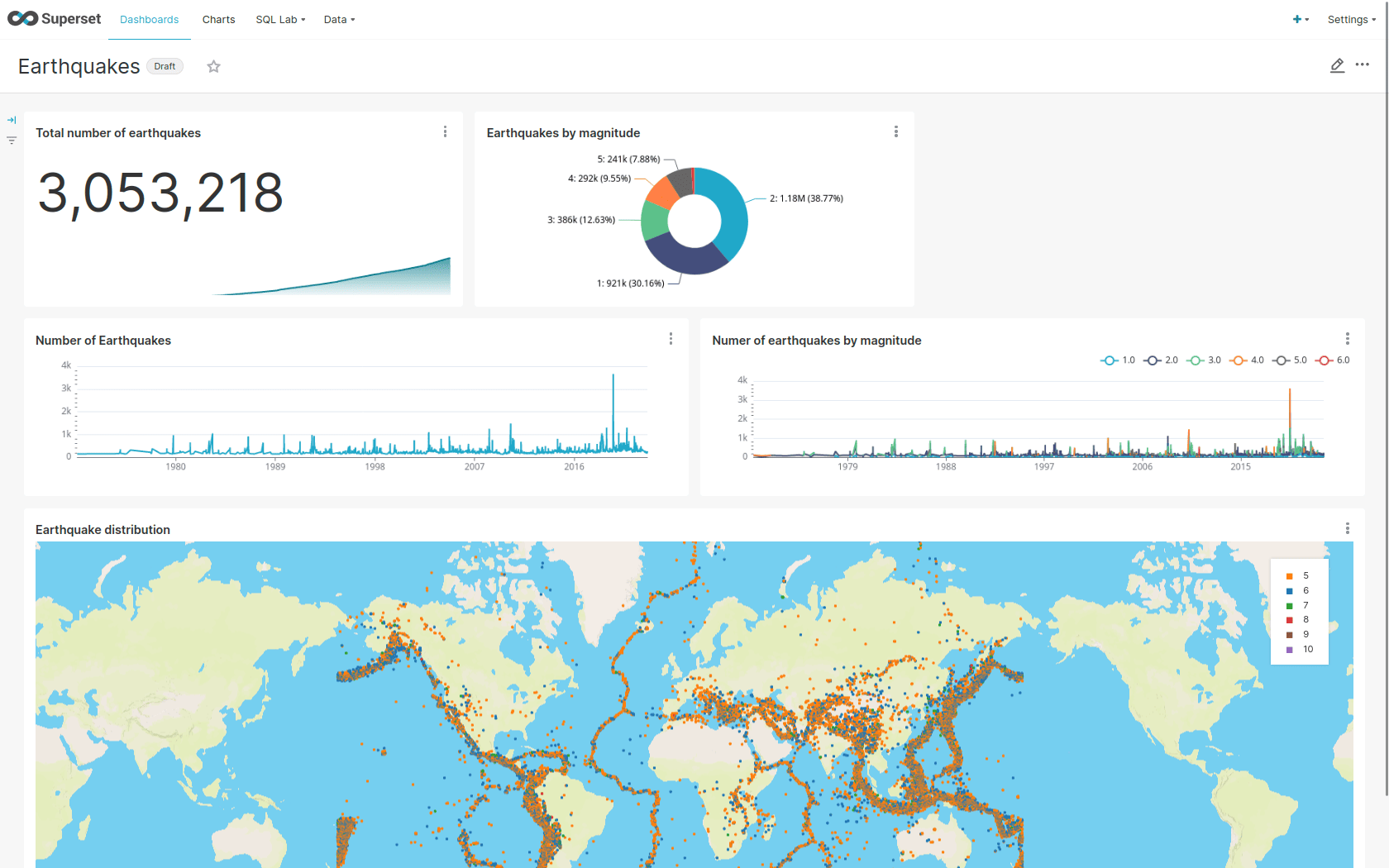

Showcase

Diese Demo der Stackable Data Platform zeigt gestreamte Erdbeben-Daten bis ins Dashboard.

Sie verwendet Apache Kafka®, Apache Nifi, Apache Druid und Apache Superset für die Visualisierung.

Unser Spezialist für Event Streaming

Mehr Infos?

Kontaktiere Lars Francke:

Lars Francke

CTO & Co-Founder von Stackable

Zum Newsletter anmelden

Newsletter

Zum Newsletter anmelden

Mit dem Stackable Newsletter bist Du immer auf dem Laufenden, wenn es um Updates rund um Stackable geht!