Open Source Datenplattform

Die Open-Source-Datenplattform

Kombination von Best Practices

Beliebte Data Apps, einfach zu verwenden

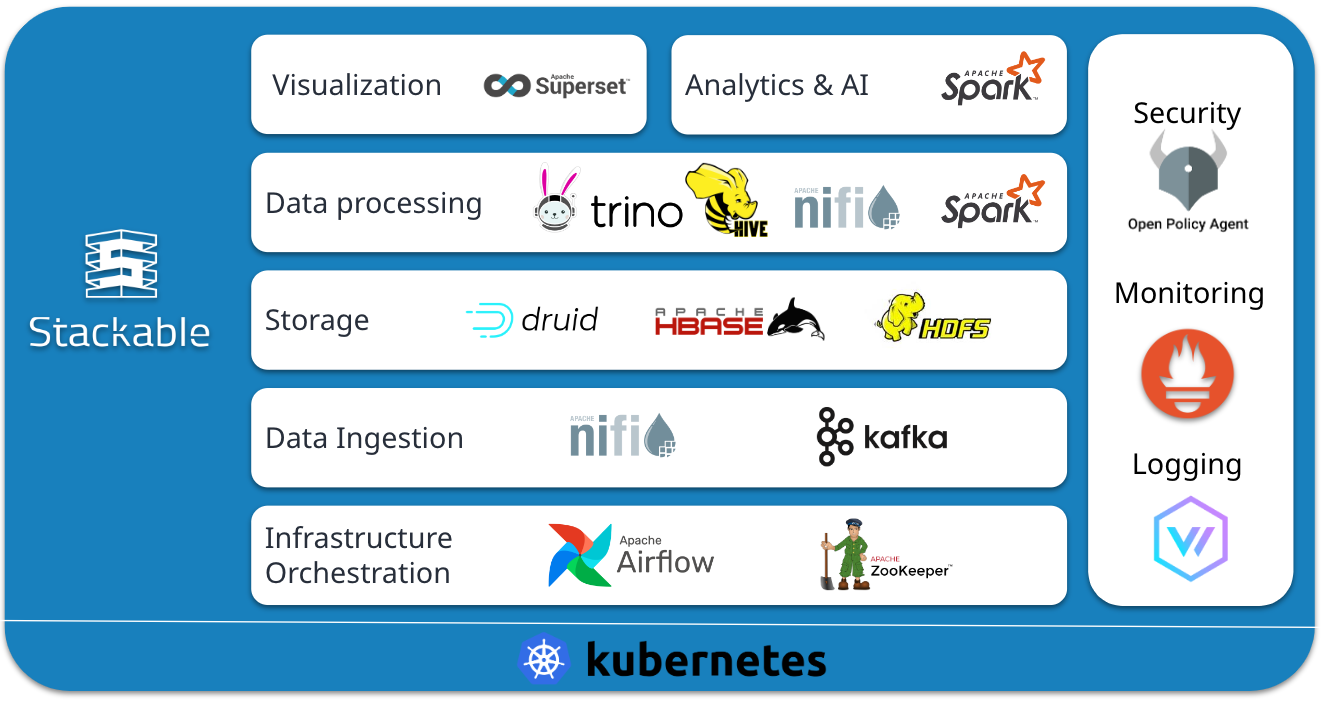

Stackable bietet Dir eine abgestimmte Auswahl der besten Open Source Data Apps wie Apache Kafka®, Apache Druid, Trino und Apache Spark™. Speichere, verarbeite und visualisiere Deine Daten mit den neuesten Versionen. Bleibe auf der Höhe der Zeit, nicht hinter ihr.

Sämtliche Data Apps arbeiten nahtlos zusammen und können im Handumdrehen hinzugefügt oder entfernt werden. Basierend auf Kubernetes läuft die Plattform überall – im eigenen Datencenter oder in der Cloud.

Erstelle einzigartige und unternehmensweite Datenarchitekturen. Die Plattform unterstützt z. B. moderne Data Warehouses, Data Lakes, Event Streaming, Machine Learning oder Data Meshes.

Cloud-native Kubernetes-Operatoren

Stackable Module sind reguläre Kubernetes-Operatoren. Aufgrund der ausgezeichneten Performance, des geringen Speicherbedarfs sowie der Speicher- und Thread-Sicherheit haben wir uns für die Programmiersprache Rust entschieden.

So geht's

Von einfachen bis zu komplexen Umgebungen mit Infrastructure as Code

Stackable bietet die Flexibilität, sowohl einfache als auch komplexe Datenszenarien zu definieren. Egal wie, die Einrichtung ist immer so einfach wie hier:

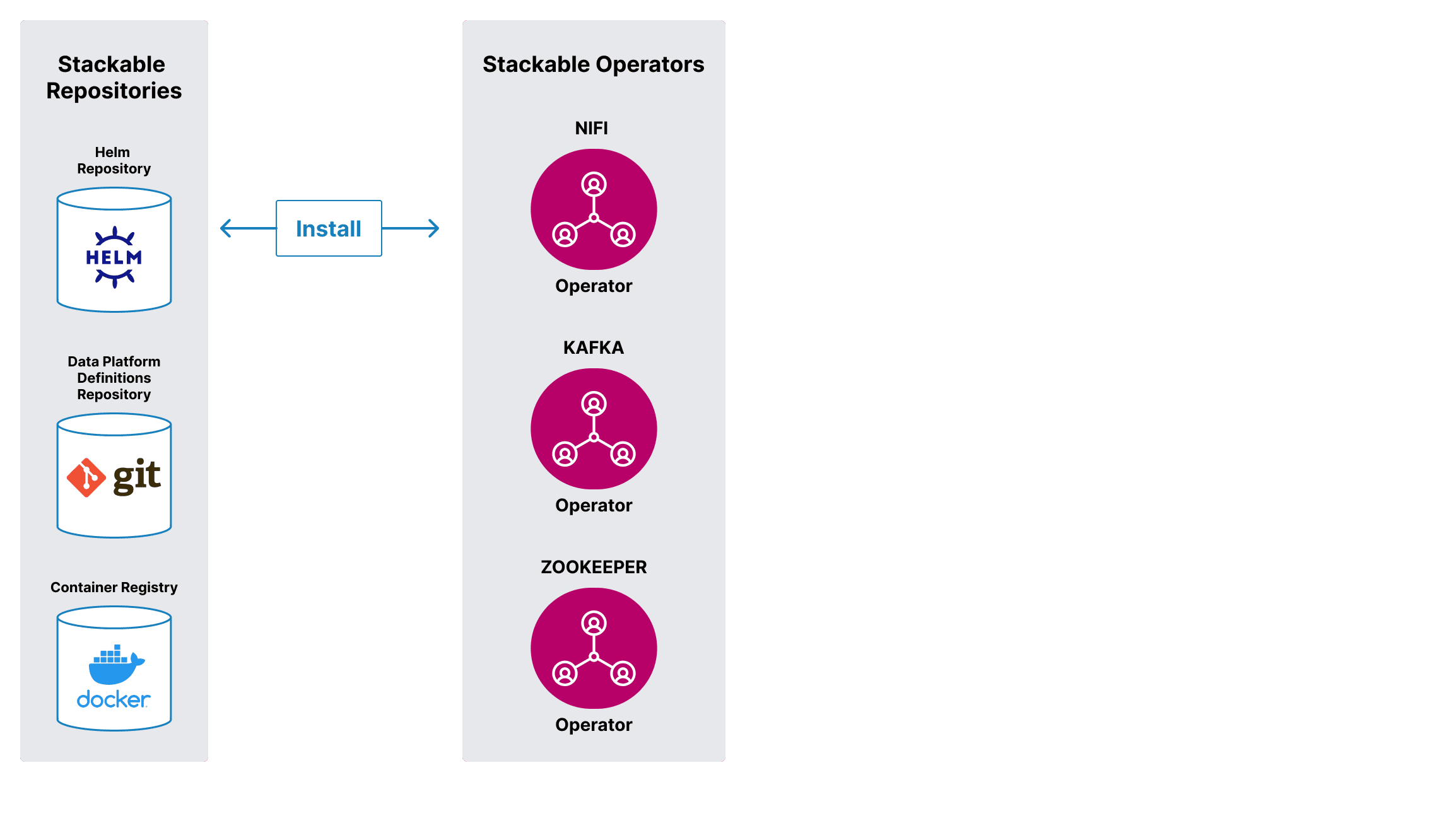

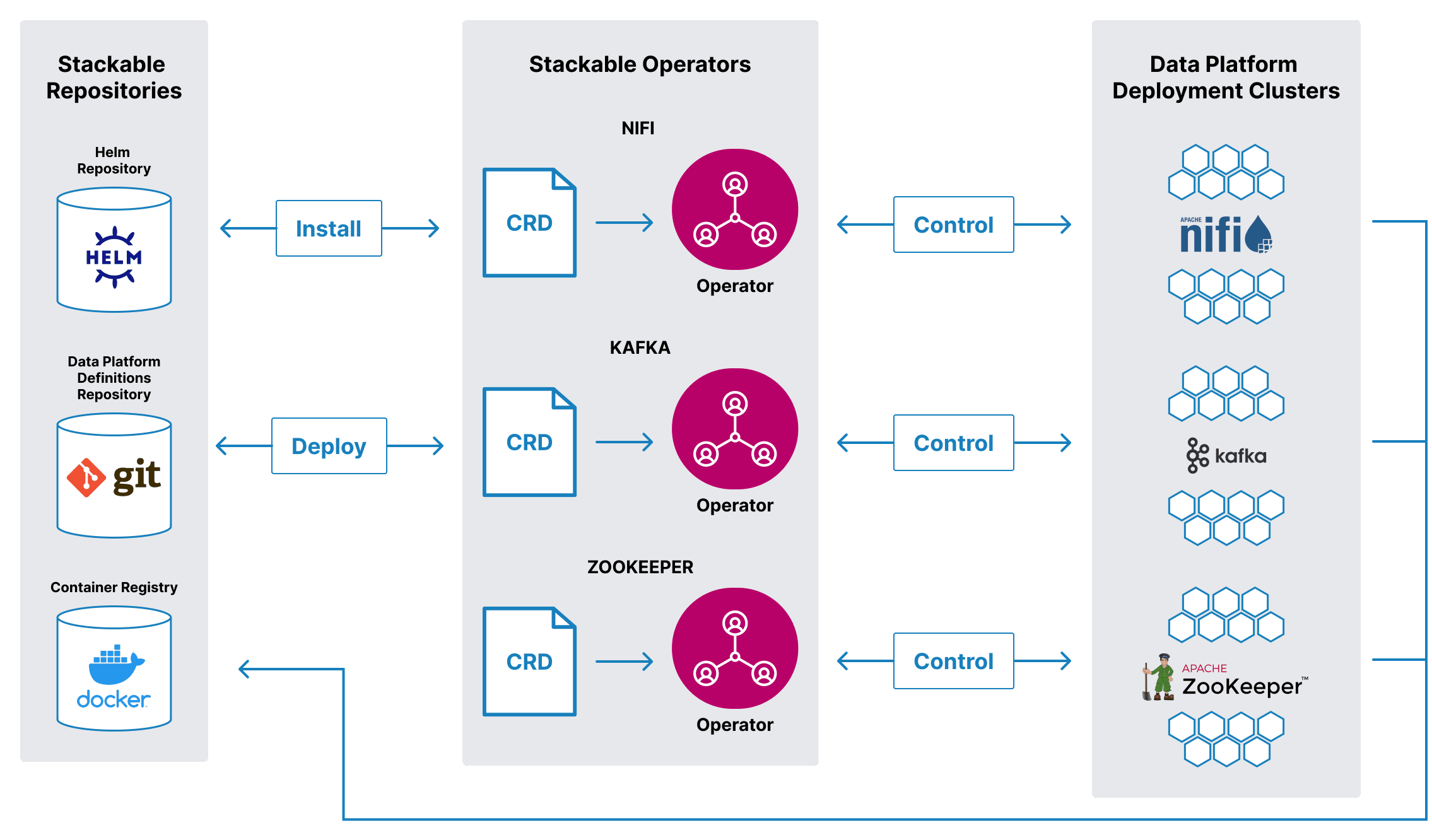

1. In Schritt eins wählst Du die Stackable-Operatoren für die Data Apps aus, die Du für Deine Datenplattform benötigst und installierst sie mit stackablectl oder direkt über Helm.

2. In Schritt zwei installierst Du Deine Data Apps im Kubernetes Cluster, indem Du die passenden Konfigurationen (CRDs) mit stackablectl oder direkt über kubectl an die Operatoren übergibst.

Alle diese Definitionen werden als Infrastructure as Code verwaltet, sodass auch die Einrichtung die Möglichkeit bietet, zu testen und zu wiederholen und so zu standardisieren.

Zum Newsletter anmelden

Newsletter

Zum Newsletter anmelden

Mit dem Stackable Newsletter bist Du immer auf dem Laufenden, wenn es um Updates rund um Stackable geht!