Demos

Demos

Einsatzmöglichkeiten der Stackable Data Platform

Die nachfolgenden Anwendungsbeispiele demonstrieren, wie einfach und flexibel sich die Stackable Data Platform für sehr unterschiedliche Anwendungsfälle einsetzen lässt. Alle Demos fokussieren bewusst auf jeweils ein Themengebiet und:

- nutzen stackablectl zur Installation

- lassen sich 1:1 bei Dir aufsetzen

- demonstrieren Zusammenhänge schrittweise

- sind als Open Source Code in Github verfügbar

Demo: jupyterhub-keycloak

Stackable und JupyterHub

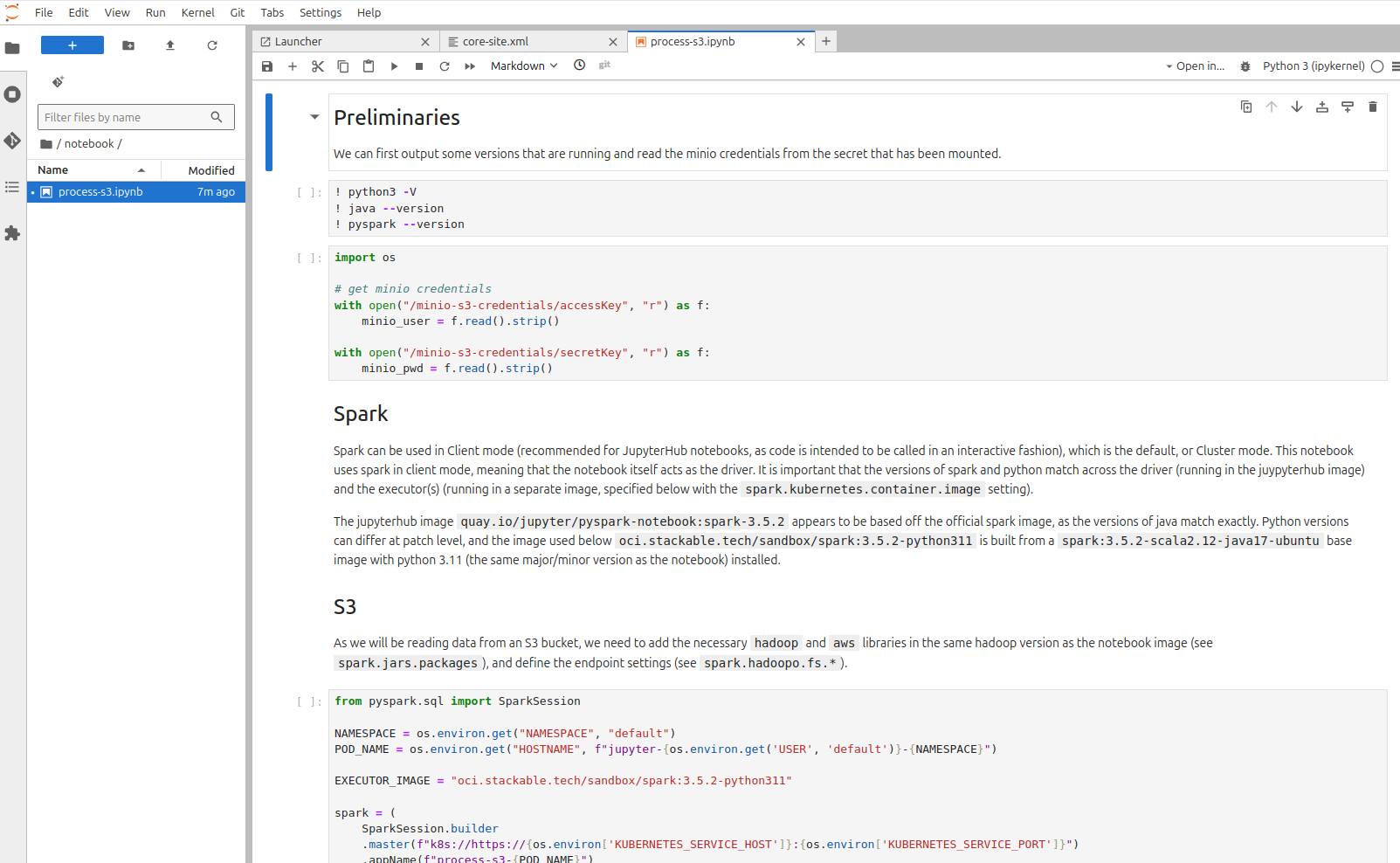

Diese Demo zeigt eine umfassende Multi-User Data Science-Umgebung auf Kubernetes, die die Stackable Data Platform mit JupyterHub und Keycloak für eine robuste Benutzerauthentifizierung und Identitätsverwaltung integriert.

Highlights:

- Authentifizierung für JupyterHub: Verwendet Keycloak für die Verwaltung des Benutzerzugriffs und gewährleistet sichere und verwaltbare Authentifizierungsprozesse.

- Dynamische Spark-Integration: Demonstriert die Fähigkeit, einen verteilten Spark-Cluster direkt von einem Jupyter-Notebook aus zu starten, mit dynamischer Ressourcenzuweisung, die auf die Bedürfnisse der Benutzer zugeschnitten ist.

- S3-Speicher-Interaktion: Veranschaulicht das Lesen von und Schreiben auf einen S3-kompatiblen Speicher (MinIO) mit Spark, mit sicherer Verwaltung von Anmeldeinformationen durch Kubernetes-Geheimnisse.

- Skalierbar und flexibel: Nutzt Kubernetes für ein skalierbares Ressourcenmanagement und ermöglicht es Benutzern, je nach Bedarf aus vordefinierten Ressourcenprofilen auszuwählen.

- Benutzerfreundliche GUI: Bietet eine intuitive Umgebung für Data Scientists zum einfachen Umgang mit gängigen Datenoperationen.

Komponenten der Demo:

- JupyterHub: Ein Mehrbenutzer-Server für Jupyter-Notebooks, der die kollaborative Datenanalyse und -verarbeitung ermöglicht.

- Keycloak: Eine Lösung zur Identitäts- und Zugriffsverwaltung, die die Authentifizierung und Autorisierung von Usern übernimmt.

- MinIO: Eine S3-kompatible Speicherlösung zum sicheren Speichern und Abrufen von Daten.

- Apache Spark: Eine einheitliche Analyse-Engine für die Verarbeitung großer Datenmengen, die so konfiguriert ist, dass sie im Client-Modus mit dynamischem Executor-Management läuft.

Inhalt der Demo:

- Installation: Die Demo wird mit einem einfachen Befehl auf einem bestehenden Kubernetes-Cluster installiert, wobei automatisch auch alle erforderlichen Operatoren und Datenprodukte eingerichtet werden.

- Zugriff auf JupyterHub: User navigieren zur JupyterHub-Weboberfläche und melden sich mit vordefinierten Anmeldedaten an, die über Keycloak authentifiziert werden.

- Datenverarbeitung: User können ein Notebook-Profil auswählen und mit der Verarbeitung von Daten mithilfe der bereitgestellten Notebooks beginnen, die verschiedene Datenoperationen gegen S3-Speicher demonstrieren.

- Multi-User-Umgebung: Die Demo unterstützt mehrere gleichzeitige User, alle mit eigenen isolierten Umgebungen für Datenverarbeitungsaufgaben.

Diese Demo bietet eine robuste Vorlage für Data Scientists zur Erstellung komplexer Datenoperationen in einer sicheren und skalierbaren Umgebung.

Weitere Details und Anpassungsoptionen findest Du im Demo-Notebook und in den Konfigurationsdateien. Mehr dazu erfährst Du in der Dokumentation.

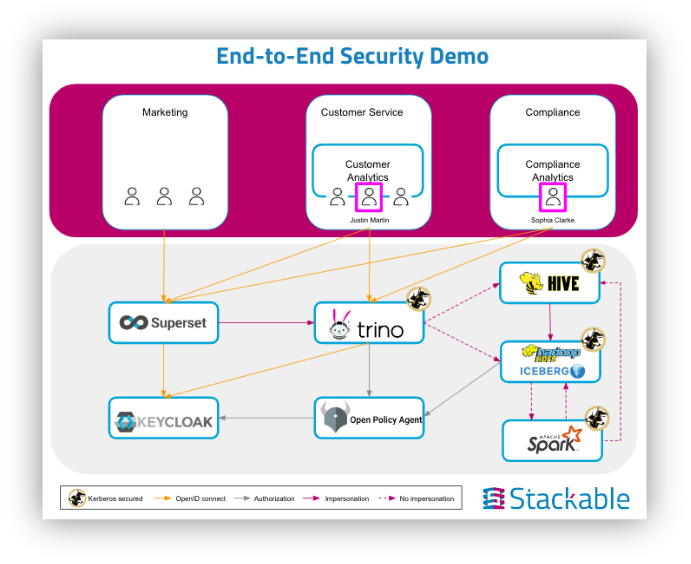

Demo: end-to-end-security

Integrierte Datensicherheit

This technology demo showcases some of Stackable’s latest features, focusing on end-to-end security:

It shows how single sign-on works across the platform and how impersonation allows for separation of access to the underlying data. It also demonstrates advanced use cases such as row-level security and data masking for critical data.

The demo uses a data lakehouse schema extract of TPC-DS, a decision support benchmark, illustrating the platform’s robust analytics capabilities.

Technologically, elements of previous demos are included, such as:

- HDFS w/ Iceberg: The Hadoop Distributed File System, used for scalable and reliable storage of large volumes of data. Configured to use Apache Iceberg as table format.

- Hive: A data warehouse infrastructure built on top of Hadoop, allowing for data summarization, querying, and analysis.

- Trino: A fast distributed SQL engine for interactive analytics. It provides powerful SQL querying capabilities over large datasets.

- Open Policy Agent (OPA): A general-purpose policy engine that provides fine-grained control and unified policy enforcement across various Stackable data apps.

- Superset: A modern data exploration and visualization platform, enabling intuitive data insights.

- Spark: A unified analytics engine for large-scale data processing, used here to perform data engineering, data science, and machine learning.

Außerdem zeigt die Demo neue Sicherheitskomponenten:

- Kerberos: Ein Netzwerk-Authentifizierungsprotokoll, das entwickelt wurde, um eine starke Authentifizierung für Client-Server-Anwendungen unter Verwendung von Kryptographie mit geheimen Schlüsseln zu ermöglichen, und jetzt auf Kubernetes für eine sichere Authentifizierung läuft.

- Rego-Regeln: Die Policy-Sprache für OPA, die die Erstellung komplexer Policy-Entscheidungen für eine feingranulare Zugriffskontrolle ermöglicht.

- OpenID Connect (OIDC): Eine einfache Identitätsschicht, die auf dem OAuth 2.0-Protokoll aufbaut und es Clients ermöglicht, die Identität von Nutzern zu überprüfen und deren Profilinformationen sicher abzurufen.

- Keycloak: Zusätzlich zur der Stackable Data Platform – eine Open-Source-Lösung für die Identitäts- und Zugriffsverwaltung. Sie verwaltet die Benutzerauthentifizierung und -autorisierung und bietet Single Sign-On (SSO) für verschiedene Anwendungen.

Das Ergebnis ist ein für die fiktive „knab“-Organisation erstelltes leistungsstarkes und sicheres Template für einen modernen Data Stack mit der Stackable Data Platform.

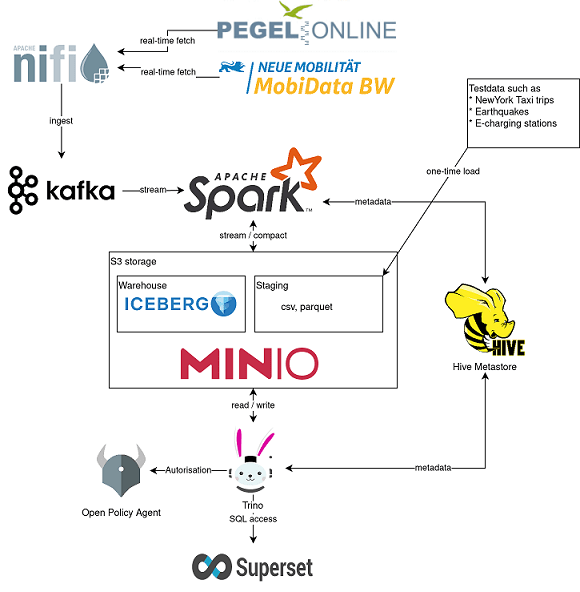

Demo: data-lakehouse-iceberg-trino-spark

Data Lakehouse Technologie Showcase

Diese Technologie-Demo zeigt einige der Funktionen der neuesten Features von Stackable.

Die Demo enthält Elemente früherer Demos, z.B.

- Echtzeit-Event-Streaming mit Apache NiFi

- Trino für SQL-Zugriff und

- visuelle Datenanzeige und -analyse mit Apache Superset

Zusätzlich enthält die Demo aber auch neue Lakehouse-Funktionen wie die Integration mit Apache Iceberg, die z. B. transaktionale Konsistenz und vollständige Schema-Evolution bietet.

Das Ergebnis ist eine umfassende Vorlage für einen modernen Data Stack mit der Stackable Data Platform.

Weitere Highlights der Demo:

- Apache Spark: Eine mehrsprachige Engine für die Ausführung von Data Engineering, Data Science und maschinellem Lernen. In dieser Demo wird es verwendet, um Daten von Kafka in das Lakehouse zu streamen.

- Open Policy Agent (OPA): Eine quelloffene, universell einsetzbare Policy-Engine, die die Durchsetzung von Richtlinien im gesamten Stack vereinheitlicht. In dieser Demo wird sie als Autorisierer für Trino verwendet, um zu entscheiden, welcher Benutzer welche Daten abfragen darf.

HOW-TO zum Starten,

im Kubernetes-Cluster:

stackablectl demo install data-lakehouse-iceberg-trino-spark

(Hinweis: getestet mit 10x4Core Nodes jeweils mit 20GB RAM ind 30GB HDD, Persistent Volumes mit Gesamtgröße ca. 1TB)

Anmerkung: für ein kleineres Setup, schau Dir gern unsere trino-iceberg Demo an:

stackablectl demo install trino-iceberg

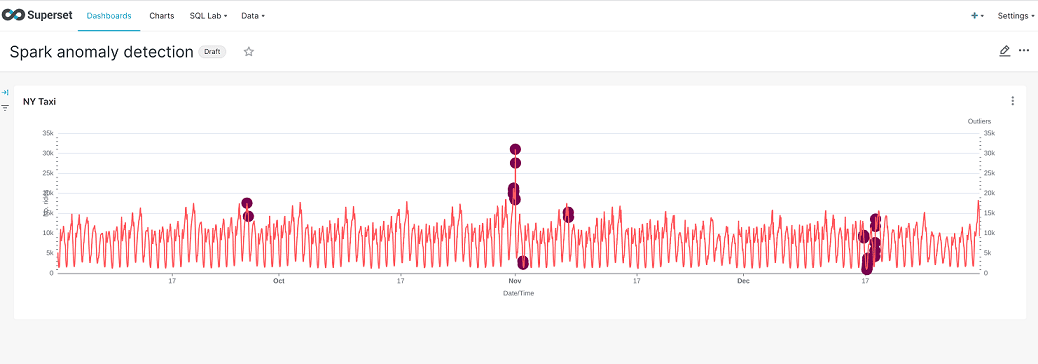

Demo: SPARK-K8S-ANOMALY-DETECTION-TAXI-DATA

Machine Learning zur Ausreißererkennung

Diese Stackable-Data-Platform-Demo stellt eine Erweiterung der ursprünglichenTRINO-TAXI-DATA-Demo um Apache Spark™ dar.

Ein oft vernachlässigter Faktor beim Einsatz von Daten zum Machine Learning ist die Datenqualität. Falschmessungen, fehlende Werte und ähnliches verfälschen die spätere Prognosequalität. In bestimmten Szenarien sind Spitzen, Ausreißer oder andere Anomalien in den Daten auch relevant, in dem sie eine Grundlage für die Definition von Warnmeldungen bilden können.

Somit liefert die Erkennung von Ausreißern einen wichtigen Beitrag für die erfolgreiche Nutzung von Daten. Wissenschaft und Wirtschaft setzen in der Praxis hier heutzutage eine Vielzahl an Verfahren und Methoden ein.

In dieser Demo erfolgt die Ausreißererkennung exemplarisch mit Apache Spark, indem ein Isolation Forest Algorithmus auf die Daten ausgeführt wird. Der Isolation-Forest-Algorithmus wird für das unüberwachte Modelltraining (unsupervised model training) verwendet, was bedeutet, dass das Modell ohne Labelling auskommt.

Ergebnisse der Erkennung werden im Apache Iceberg Format gespeichert und mit Apache Superset visualisiert.

HOW-TO zum Starten,

im Kubernetes-Cluster:

stackablectl demo install spark-k8s-anomaly-detection-taxi-data

Demo: NIFI-kafka-druid-water-level-data

Echtzeitanzeige von Wasserpegelständen

Niedrigwasser oder Überschwemmungsgefahr – die Wasserpegel unserer Flüsse sind in Zeiten des Klimawandels ins öffentliche Interesse gerückt.

Unsere Stackable-Data-Platform-Demo zeigt die Pegelstände von Flüssen nahezu in Echtzeit auf Basis der Daten von Pegel Online.

Mehrere Komponenten der Stackable Data Platform spielen dabei zusammen, ohne dass dafür ein großer Konfigurationsaufwand notwendig ist:

Mit Apache Nifi und Apache Kafka werden Pegelstandsmessungen von deutschlandweit verteilten Messstationen über eine API von Pegel Online abgeholt und in Apache Druid gespeichert.

Druid ist eine skalierbare Echtzeitdatenbank, die mittels SQL abgefragt werden kann. Diese Methode wird in der Demo genutzt, um über Apache Superset die Pegelstände abzufragen und im Dashboard zu visualisieren. Für die dauerhafte Speicherung benötigt Druid einen sogenannten „Deep Storage“, der in unserem Beispiel über MinIO als S3-kompatibler Objektspeicher, wie er in den meisten öffentlichen und privaten Cloud-Umgebungen vorhanden ist, realisiert wird.

HOW-TO zum Starten,

im Kubernetes-Cluster:

stackablectl demo install nifi-kafka-druid-water-level-data

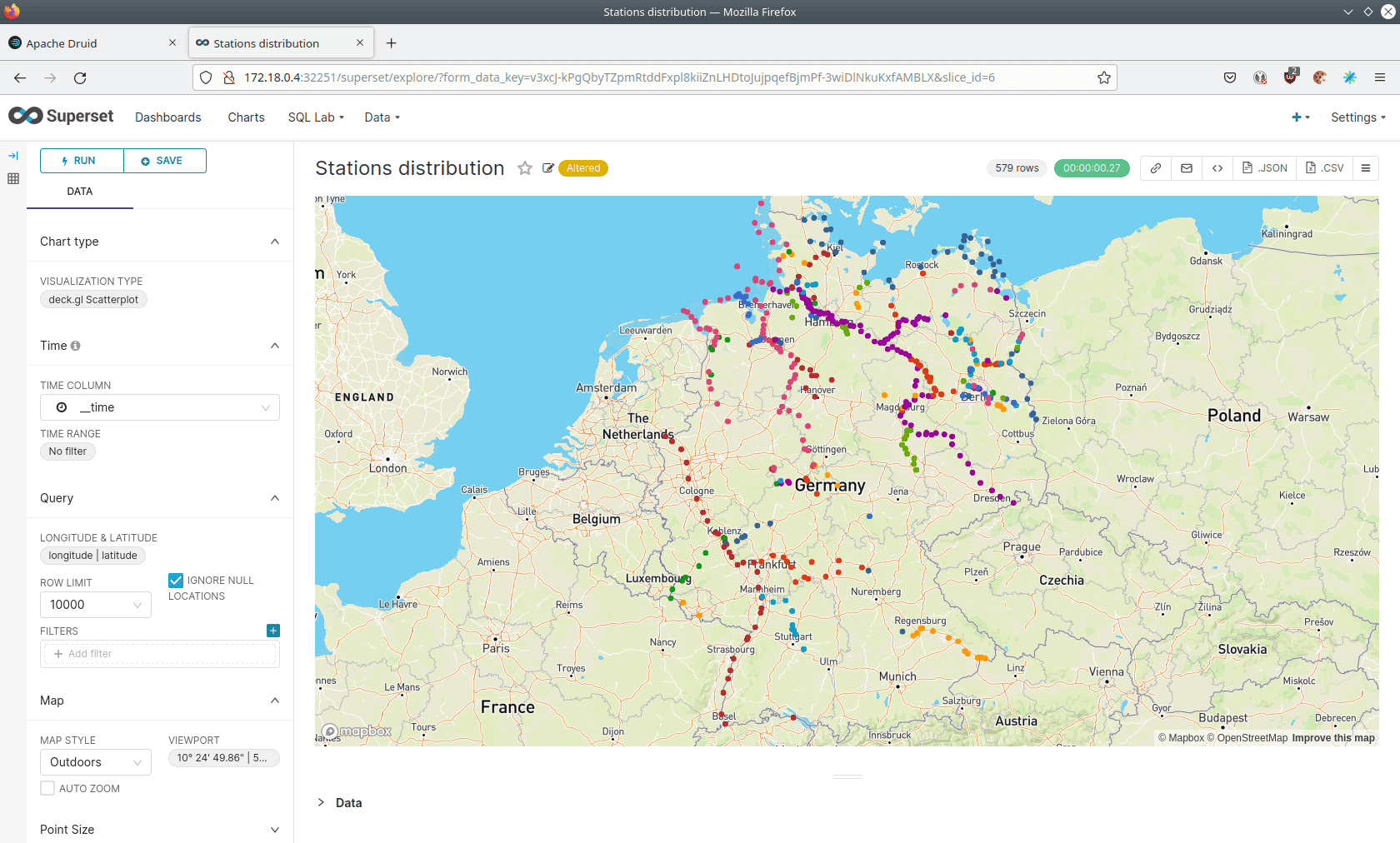

Demo: trino-taxi-data

Analysen mit einem Data Lake

Diese Stackable-Data-Platform-Demo zeigt in S3 gespeicherte Daten für die Analyse und bis zur Anzeige im Dashboard.

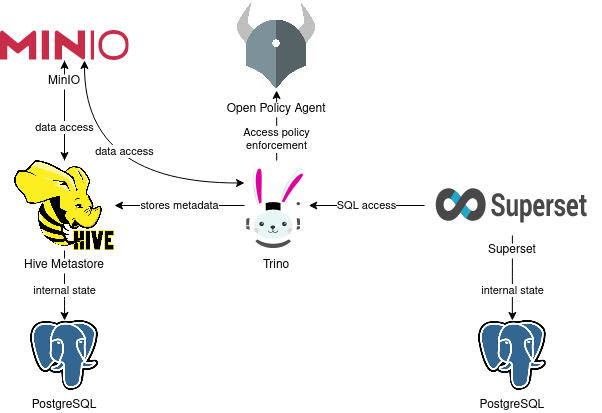

Mit unseren Stackable-Operatoren werden verschiedene Komponenten konfiguriert und ausgerollt. Dieses Beispiel zeigt insbesondere, wie ein rollenbasierter Datenzugriff über den Open Policy Agent realisiert werden kann:

- In MinIO, einem S3-kompatiblen Objektspeicher, werden die Daten für diese Demo persistent gespeichert.

- Hive-Metastore speichert die notwendigen Metadaten, um die Beispieldaten über SQL zugreifbar zu machen und wird in unserem Beispiel von Trino verwendet.

- Trino ist unsere extrem schnelle, verteilte SQL-Abfrage-Engine für Big-Data-Analysen, mit der sich Datenräume erkunden lassen und die wir in der Demo verwenden, um SQL-Zugriffe auf die Daten zu ermöglichen.

- Apache Superset verwenden wir schließlich, um Daten von Trino über SQL-Abfragen abzurufen und Dashboards auf diesen Daten aufzubauen.

Open Policy Agent (OPA): Eine quelloffene, universelle Policy Engine, die die Durchsetzung von Richtlinien im gesamten Stack vereinheitlicht. In dieser Demo autorisiert OPA, welcher Benutzer welche Daten abfragen darf.

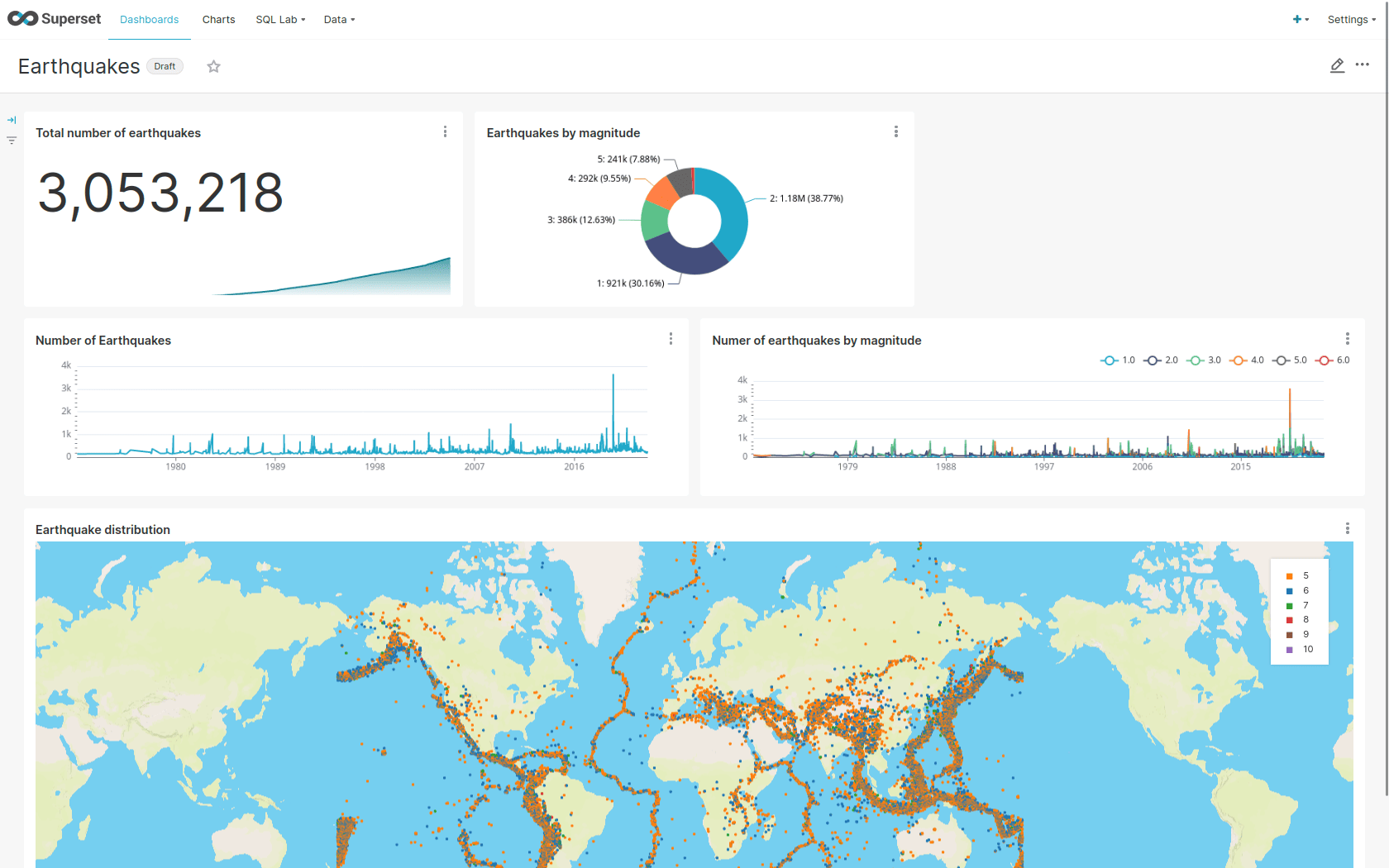

Demo: NIFI-kafka-druid-earthquake-data

Event Streaming von Erdbeben-Daten

Diese Stackable-Data-Platform-Demo zeigt gestreamte Erdbebendaten bis zur Anzeige im Dashboard.

Sie enthält folgende Operatoren:

Apache Superset: Eine moderne Plattform zur Datenexploration und -visualisierung. Diese Demo nutzt Superset, um Daten von Druid über SQL-Abfragen abzurufen und Dashboards auf diesen Daten aufzubauen.

Apache Kafka®: Eine verteilte Event-Streaming-Plattform für leistungsstarke Datenpipelines, Streaming-Analysen und Datenintegration. In dieser Demo wird Kafka als Event-Streaming-Plattform verwendet, um die Daten nahezu in Echtzeit zu streamen.

Apache Nifi: Ein einfach zu bedienendes, leistungsstarkes System zur Verarbeitung und Verteilung von Daten. Diese Demo verwendet es, um Erdbebendaten aus dem Internet zu holen und in Kafka zu übertragen.

Apache Druid: Eine Echtzeit-Datenbank zur Unterstützung moderner Analyseanwendungen. Diese Demo verwendet Druid, um Daten nahezu in Echtzeit aus Kafka aufzunehmen, zu speichern und den Zugriff auf die Daten über SQL zu ermöglichen.

MinIO: Ein S3-kompatibler Objektspeicher. In dieser Demo wird er als persistenter Speicher für Druid verwendet, um alle gestreamten Daten zu speichern.

HOW-TO zum Starten,

im Kubernetes-Cluster:

stackablectl demo install nifi-kafka-druid-earthquake-data

Du hast Fragen oder Anmerkungen?

Mehr Infos?

Kontaktiere Sönke Liebau, um mit uns in Kontakt zu treten:

Sönke Liebau

CPO & CO-FOUNDER von Stackable

Subscribe to our Newsletter

Newsletter

Subscribe to the newsletter

With the Stackable newsletter you’ll always be up to date when it comes to updates around Stackable!