Data Lakehouse

Data Lakehouse

Kombination von Data Lake und Data Warehouse

Stackable für Data Lakehouses

Die Stackable Data Platform bietet eine umfassende Lösung für die Implementierung einer Data Lakehouse-Architektur. Sie kombiniert die Flexibilität und Skalierbarkeit eines Data Lakes nahtlos mit den Verwaltungsfunktionen und dem strukturierten Zugriff eines Data Warehouses.

Das Data Lakehouse

Ein Data Lakehouse stellt einen innovativen Ansatz für die Datenarchitektur dar, bei dem sich die umfangreichen Datenspeicherfunktionen von Data Lakes mit den strukturierten Abfrage- und Datenverwaltungsfunktionen von Data Warehouses vereinen. Mit der Stackable Data Platform können Unternehmen Kubernetes für die Bereitstellung und Skalierung ihrer Data Lakehouse-Architektur nutzen und so Flexibilität, Effizienz und Hochverfügbarkeit in ihren Datenökosystemen sicherstellen.

Die Data Lakehouse-Architektur der Stackable Data Platform eignet sich für Organisationen, die Daten für die digitale Transformation nutzen und die geschäftliche Agilität verbessern möchten.

Data App Highlights der Stackable Data Platform für Data Lakehouses

Delta Lake

Ermöglicht den Import, das Management des Datenflusses sowie den automatisierten Datenaustausch zwischen Systemen.

- Einfaches Daten-Routing und Transformation: Bietet eine benutzerfreundliche Oberfläche für das Management des Datenflusses und unterstützt die schnelle Entwicklung und Bereitstellung von Verarbeitungspipelines.

- Systemintegration: Verbindet sich mit einer Vielzahl von Datenquellen und -senken und erleichtert die Datenaufnahme aus unterschiedlichen Systemen.

- Data Lineage: Nachverfolgung des Datenflusses von der Quelle bis zum Ziel, Unterstützung von Audits und Compliance.

- Flexibel: Anpassbare Prozessoren und die Fähigkeit, verschiedene Datenformate und -größen zu verarbeiten.

Optimierung von Daten-Workflows mit Präzision und Skalierbarkeit.

- Erweiterte Workflow-Orchestrierung: Apache Airflow bietet die umfassende Planung und Verwaltung von Workflows, die eine präzise Steuerung von Datenverarbeitungsaufgaben innerhalb der Stackable Data Platform ermöglicht.

- Dynamische Erstellung von Pipelines: Mit Hilfe der intuitiven Benutzeroberfläche und des leistungsstarken Programmier-Frameworks von Airflow lassen sich komplexe Datenpipelines einfach definieren, planen und überwachen.

- Skalierbar und verlässlich: Airflow lässt sich einfach skalieren. Gleichzeitige Workflows lassen sich mühelos handhaben, so dass Datenaufgaben unabhängig vom Volumen zuverlässig ausgeführt werden.

- Effizientes Monitoring und Protokollierung: Die Monitoringfunktionen von Airflow ermöglichen eine schnelle Identifizierung und Lösung von Problemen und gewährleisten einen reibungslosen Datenbetrieb.

Bietet leistungsstarke Datenverarbeitungsfunktionen, die verteilte Analysen und maschinelles Lernen auf großen Datensätzen ermöglichen.

- In-Memory-Computing: Beschleunigt die Verarbeitungsgeschwindigkeit, indem es die Daten im RAM speichert, deutlich schneller als festplattenbasierte Alternativen.

- Erweiterte Analysen: Unterstützt komplexe Algorithmen für maschinelles Lernen, Graphenverarbeitung und mehr.

- Fehlertoleranz: Resiliente verteilte Datensätze (RDDs) bieten Fehlertoleranz durch Herkunftsinformationen.

- Sprachunterstützung: Bietet APIs in Python, Java, Scala und R und erweitert damit die Zugänglichkeit und Nutzbarkeit.

Ermöglicht den (virtualisierten) Datenzugriff über verschiedene Datenquellen hinweg und verbessert die Flexibilität und Geschwindigkeit von Abfragen in Datenarchitekturen.

- Flexible Tabellenformate: Unterstützung von Apache Iceberg und Delta Lake.

- Schnelle Antwortzeiten: Entwickelt für performante Datenabfragen über verteilte Datenquellen hinweg.

- Föderierte Abfragen: Ermöglicht die Abfrage von Daten aus mehreren Quellen und vereinfacht die Analyse über unterschiedliche Datenspeicher (Data Federation).

- Skalierbar und flexibel: Einfache Skalierung für große Datensätze und komplexe Abfragen.

- Benutzerfreundlich: Unterstützt SQL für Abfragen und ist damit auch für Benutzer geeignet, die mit relationalen Datenbanken vertraut sind.

Delta Lake

Stackable unterstreicht sein Engagement für offene und flexible Datenlösungen durch die Integration von zwei erstklassigen Tabellenformaten: Apache Iceberg und Delta Lake. Unsere Kunden können somit die beste Option für ihre spezifischen Anforderungen auswählen. Im Folgenden erläutern wir die wichtigsten Faktoren, die bei der Wahl zwischen Delta Lake und Apache Iceberg zu berücksichtigen sind. Wir empfehlen jedoch immer die Durchführung von Tests mit realen Anwendungsfällen, um eine möglichst genaue Entscheidung treffen zu können.

Apache Iceberg:

- Optimal, wenn besonderer Wert auf Benutzerfreundlichkeit und plattformübergreifende Kompatibilität gelegt wird.

- Unterstützt die kontinuierliche Schemaevolution und die Analyse großer Datenzeiträume.

- Aufgrund seiner effizienten Abfrageperformance besonders geeignet für Data Warehousing-Anforderungen.

Delta Lake:

- Perfekt abgestimmt auf Benutzer, die bereits Delta Lake-Architekturen verwenden.

- Hervorragend geeignet für Setups, die ACID-Transaktionen und hohe Datenintegrität erfordern.

- Optimal in Umgebungen, in denen hohe Datenintegrität entscheidend ist.

Integration von fortschrittlicher Data Governance und feingranularer Zugriffskontrolle im Data Lakehouse.

- Einheitliches Richtlinien-Framework: OPA bietet ein leistungsfähiges, einheitliches Framework für die Steuerung des Zugriffs im gesamten Data Lakehouse und gewährleistet die konsistente Durchsetzung von Sicherheitsrichtlinien, Datenschutzbestimmungen und Compliance-Anforderungen.

- Deklarative Richtlinien als Code: Governance-Richtlinien erfolgen deklarativ mit Rego, der OPA-Syntaxsprache. Dieser Ansatz ermöglicht die Entwicklung klarer, verständlicher Richtlinien, die als Teil Ihrer CI/CD-Pipeline versionskontrolliert, überprüft und bereitgestellt werden können.

- Detaillierte Zugriffskontrolle: Feingranulare Kontrolle über den Datenzugriff und die Datenveränderung innerhalb der Data Lakehouse-Architektur.

- Skalierbar und hochleistungsfähig: OPA unterstützt auch große, komplexe Datenumgebungen und stellt sicher, dass Governance-Richtlinien effizient ausgewertet werden, ohne den Zugriff auf Daten oder die Anwendungsleistung zu beeinträchtigen.

Exemplarische Anwendungsfälle

- Entscheidungsfindung in Echtzeit: Schneller fundierte Entscheidungen treffen. Apache Airflow wird verwendet, um Datenpipelines zu automatisieren und neue Daten aufzunehmen. In Kombination mit Trino für performance Abfragen ermöglicht dieses Setup Organisationen eine rasche Anpassung an sich ändernde Marktbedingungen und betriebliche Anforderungen.

- Vertiefter Einblick ins Kundenportfolio: Apache Spark kommt für die Verarbeitung komplexer Datensätze und Trino für die Abfrage strukturierter und unstrukturierter Daten zum Einsatz, unterstützt durch moderne Datenformate wie Apache Iceberg und Delta Lake. Apache Superset visualisiert diese Erkenntnisse und fördert so personalisierte Kundenerlebnisse und strategische Entscheidungen.

- Innovative Produktentwicklung: Beschleunigte Produktinnovation, durch Verwendung der fortschrittlichen analytischen Fähigkeiten von Apache Spark und der nahtlosen Datenabfrage von Trino über verschiedene Datenquellen und -formate hinweg. Dieses fördert zudem eine Kultur des schnellen Experimentierens und Entwickelns. Apache Airflow erleichtert den Weg von der Datenerfassung bis zur Analyse und beschleunigt so den Iterationszyklus bei der Produktentwicklung.

- Optimierung von Lieferketten: Optimierte Lieferketten mit vorausschauenden Analysen, die z.B. aus Streaming-Daten abgeleitet werden. Aufnahme von Echtzeitereignissen und deren Datenverarbeitung kann mit Apache Spark erfolgen. Trino wird zur Abfrage der Daten verwendet, um dynamische Anpassungen zur Steigerung der Effizienz und zur Senkung der Betriebskosten zu ermöglichen.

- Monitoring und Analyse sozialer Medien: Integration von Social-Media-Daten mit Apache NiFi, Verarbeitung mit Apache Spark und Abfrage mit Trino, um Echtzeiteinblicke in Markttrends, Kundenstimmungen und Markenengagement zu erhalten. Diese strategischen Erkenntnisse können in Content-Strategien und Entscheidungen des Markenmanagements einfließen.

Showcase

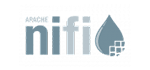

Diese Demo der Stackable Data Platform zeigt ein Data Lakehouse.

Sie verwendet Apache Kafka®, Apache Nifi, Trino mit Apache Iceberg und den Open Policy Agent.

Erfahre in unserem Blogbeitrag, wie man Stackable zur Erstellung eines Data Lakehouse einsetzen kann zusammen mit

- dbt

- Trino

- Apache Iceberg

Nutze die Einfachheit moderner ELT/ETL in einer schlanken Data Lakehouse-Architektur.

Unser Spezialist für Data Lakehouses

Mehr Infos?

Kontaktiere Sönke Liebau:

Sönke Liebau

CPO & Co-Founder von Stackable

Zum Newsletter anmelden

Newsletter

Zum Newsletter anmelden

Mit dem Stackable Newsletter bist Du immer auf dem Laufenden, wenn es um Updates rund um Stackable geht!